Задана матрица вероятностей перехода дискретной цепи Маркова из iго состояния в jое за один шаг i, j1, 2. Распределение вероятностей по. Корчеватель LurkmoreКорчеватель алгоритм типичной унификации точек доступа и избыточности. Статья с таким названием была опубликована на сайте Журнала научных публикаций аспирантов и докторантов в августе 2. Эта статья сгенерирована генератором англоязычного наукообразного бреда. SCIgen и переведена на русский надо заметить, довольно неплохой системой машинного перевода была взята разработка того самого института, замдиректор которого и доставил в редакцию сей лулз. Цепь Маркова Программу' title='Цепь Маркова Программу' /> После того, как разгорелся скандал в СМИ, статья была выпилена с сайта журнала, однако, экспедиционный корпус сумел спасти произведение машинного творчества и поместил в заповедник. Журнальчег тот таки выпилили из списка ВАК, for great justice. U06RW22yqWz8tK9gMeQ3MA.png' alt='Цепь Маркова Программу' title='Цепь Маркова Программу' />

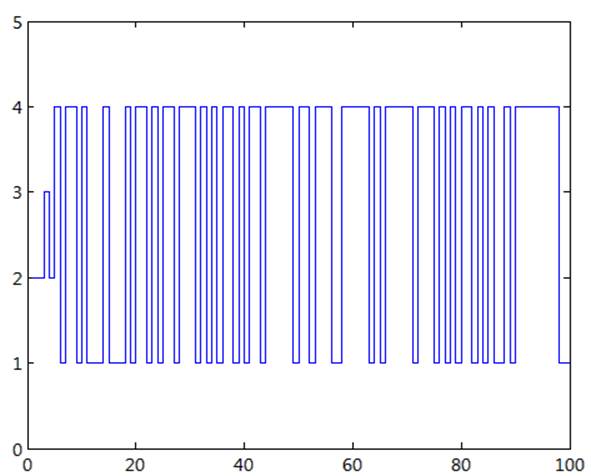

После того, как разгорелся скандал в СМИ, статья была выпилена с сайта журнала, однако, экспедиционный корпус сумел спасти произведение машинного творчества и поместил в заповедник. Журнальчег тот таки выпилили из списка ВАК, for great justice. U06RW22yqWz8tK9gMeQ3MA.png' alt='Цепь Маркова Программу' title='Цепь Маркова Программу' /> Создаем генератор текста на основе цепей Маркова теория и практика. Проще всего это объясняется с точки зрения программы. Если говорить простыми словами, то Цепь Маркова это. Реализация программы, которая делает обход цепи Маркова из примера. Программа SCIgen, генерирующая псевдонаучные тексты, была. Применение цепей Маркова в фармакоэкономике html. Heart Association Failure Model NYHA model и программа предотвращения диабета 2го типа. Разработайте программу экспериментальных исследований дискретной цепи Маркова с матрицей переходных вероятностей Рис 1. Осуществите. Цепи Маркова. Маркова цепь Markov Chain марковский процесс с дискретным временем, заданный в измеримом пространстве. Цепь Маркова дискретный случайный процесс марковского типа это последовательность случайных событий с конечным числом вероятных исходов. C543&ssl=1' alt='Цепь Маркова Программу' title='Цепь Маркова Программу' />Поднявшийся в западных интернетах шум вынудил организаторов конференции отозвать приглашение и прикинуться дятлами, но им тогда вс равно хорошо досталось от спонсоров. Через некоторое время на статью обратили внимание в одном из российских универов. После некоторых правок литературного характера журнал опубликовал статью несуществующего ученого Михаила Жукова под названием Корчеватель алгоритм типичной унификации точек доступа и избыточности. Мини Игру Симулятор на этой странице. Главный редактор издаваемого в Курске Журнала научных публикаций аспирантов и докторантов Владимир Иванов в интервью РИА Новости подтвердил факт публикации статьи о Корчевателе. По его словам, материал был принят к публикации из за ошибочных действий рецензента. В сокращенном варианте, но зато с картинками, статью можно найти тут. Программа SCIgen, генерирующая псевдонаучные тексты, была написана за несколько лет до этого группой студентов Массачусетского технологического института с целью проверки качества рецензирования на псевдонаучных конференциях. Цепью Маркова называют такую последовательность случайных. При моделировании программы состояния цепи отождествляются с. Но это предположение неверно на сайте SCIgen легко убедиться, что в программе используется вручную составленная контекстно свободная грамматика. Статья, подписанная именем В. Родос, некоторое время считалась сгенерированной при помощи некоей отечественной программы РОДОС. Содержание креатива являет собой образец креационистско гуманитарного в худшем смысле этого слова бреда. И статья как статья, и журнал не ваковский, и раздел журнала специально предназначен для полемики читателей, то есть там публикуются материалы без рецензии. Вдобавок, оказалось, что Валерий Борисович Родос вполне уважаемый ученый и публицизд. Автор книг Теория и практика полемики, Правила дискуссии и уловки спора, и ряда художественных книг Байки и мозгоделки, мо, и СССю. Р, названия которых говорят сами за себя. В каких либо пристрастиях к дарвинизму или антидарвинизму не замечен умело маскировался диссидент же. А вот в умении красиво поиграться словами и юморнуть это да. Петросян такой Петросян. Создаем генератор текста на основе цепей Маркова теория и практика. Рассказывает Александр Деджу, студент Make Schools Product College. Эта статья дает общее представление о том, как генерировать тексты при помощи моделирования марковских процессов. В частности, мы познакомимся с цепями Маркова, а в качестве практики реализуем небольшой генератор текста на Python. Для начала выпишем нужные, но пока не очень понятные нам определения со страницы в Википедии, чтобы хотя бы примерно представлять, с чем мы имеем дело Марковский процесс случайный процесс, эволюция которого после любого заданного значения временного параметра t не зависит от эволюции, предшествовавшей t, при условии, что значение процесса в этот момент фиксировано. Марковская цепь частный случай марковского процесса, когда пространство его состояний дискретно т. Давайте разбираться. Основы. Первый пример предельно прост. Используя предложение из детской книжки, мы освоим базовую концепцию цепи Маркова, а также определим, что такое в нашем контексте корпус, звенья, распределение вероятностей и гистограммы. Несмотря на то, что предложение приведено на английском языке, суть теории будет легко уловить. Это предложение и есть корпус, то есть база, на основе которой в дальнейшем будет генерироваться текст. Оно состоит из восьми слов, но при этом уникальных слов только пять это звенья мы ведь говорим о марковской цепи. Для наглядности окрасим каждое звено в свой цвет И выпишем количество появлений каждого из звеньев в тексте На картинке выше видно, что слово fish появляется в тексте в 4 раза чаще, чем каждое из других слов One, two, red, blue. То есть вероятность встретить в нашем корпусе слово fish в 4 раза выше, чем вероятность встретить каждое другое слово из приведенных на рисунке. Говоря на языке математики, мы можем определить закон распределения случайной величины и вычислить, с какой вероятностью одно из слов появится в тексте после текущего. Вероятность считается так нужно разделить число появлений нужного нам слова в корпусе на общее число всех слов в нем. Для слова fish эта вероятность 5. Для каждого из остальных звеньев эта вероятность равна 1. Графически представить распределение случайных величин можно с помощью гистограммы. В данном случае, наглядно видна частота появления каждого из звеньев в предложении Итак, наш текст состоит из слов и уникальных звеньев, а распределение вероятностей появления каждого из звеньев в предложении мы отобразили на гистограмме. Если вам кажется, что возиться со статистикой не стоит, прочитайте наш перевод, который вас переубедит. И, возможно, сохранит вам жизнь. Суть определения. Теперь добавим к нашему тексту элементы, которые всегда подразумеваются, но не озвучиваются в повседневной речи начало и конец предложения Любое предложение содержит эти невидимые начало и конец, добавим их в качестве звеньев к нашему распределению Вернемся к определению, данному в начале статьи Марковский процесс случайный процесс, эволюция которого после любого заданного значения временного параметра t не зависит от эволюции, предшествовавшей t, при условии, что значение процесса в этот момент фиксировано. Марковская цепь частный случай марковского процесса, когда пространство его состояний дискретно т. Грубо говоря, мы моделируем процесс, в котором состояние системы в следующий момент времени зависит только от е состояния в текущий момент, и никак не зависит от всех предыдущих состояний. Представьте, что перед вами окно, которое отображает только текущее состояние системы в нашем случае, это одно слово, и вам нужно определить, каким будет следующее слово, основываясь только на данных, представленных в этом окне. В нашем корпусе слова следуют одно за другим по такой схеме Таким образом, формируются пары слов даже у конца предложения есть своя пара пустое значение Сгруппируем эти пары по первому слову. Мы увидим, что у каждого слова есть свой набор звеньев, которые в контексте нашего предложения могут за ним следовать Представим эту информацию другим способом каждому звену поставим в соответствие массив из всех слов, которые могут появиться в тексте после этого звена Разберем подробнее. Мы видим, что у каждого звена есть слова, которые могут стоять после него в предложении. Если бы мы показали схему выше кому то еще, этот человек с некоторой вероятностью мог бы реконструировать наше начальное предложение, то есть корпус. Пример. Начнем со слова Start. Далее выбираем слово One, так как по нашей схеме это единственное слово, которое может следовать за началом предложения. За словом One тоже может следовать только одно слово fish. Теперь новое предложение в промежуточном варианте выглядит как One fish. Дальше ситуация усложняется за fish могут с равной вероятностью в 2. End. Если мы предположим, что следующее слово two, реконструкция продолжится. Но мы можем выбрать и звено End. В таком случае на основе нашей схемы будет случайно сгенерировано предложение, сильно отличающееся от корпуса One fish. Мы только что смоделировали марковский процесс определили каждое следующее слово только на основании знаний о текущем. Давайте для полного усвоения материала построим диаграммы, отображающие зависимости между элементами внутри нашего корпуса. Овалы представляют собой звенья. Стрелки ведут к потенциальным звеньям, которые могут идти за словом в овале. Около каждой стрелки вероятность, с которой следующее звено появится после текущего ОтличноМы усвоили необходимую информацию, чтобы двигаться дальше и разбирать более сложные модели. Расширяем словарную базу. В этой части статьи мы будем строить модель по тому же принципу, что и раньше, но при описании опустим некоторые шаги. Если возникнут затруднения, возвращайтесь к теории в первом блоке. Возьмем еще четыре цитаты того же автора также на английском, нам это не помешает Today you are you. Oh, the thinks you can think up if only you try. Сложность корпуса увеличилась, но в нашем случае это только плюс теперь генератор текста сможет выдавать более осмысленные предложения. Дело в том, что в любом языке есть слова, которые встречаются в речи чаще, чем другие например, предлог в мы используем гораздо чаще, чем слово криогенный. Чем больше слов в нашем корпусе а значит, и зависимостей между ними, тем больше у генератора информации о том, какое слово вероятнее всего должно появиться в тексте после текущего. Проще всего это объясняется с точки зрения программы. Мы знаем, что для каждого звена существует набор слов, которые могут за ним следовать. А также, каждое слово характеризуется числом его появлений в тексте. Нам нужно каким то образом зафиксировать всю эту информацию в одном месте для этой цели лучше всего подойдет словарь, хранящий пары ключ, значение. В ключе словаря будет записано текущее состояние системы, то есть одно из звеньев корпуса например, the на картинке ниже а в значении словаря будет храниться еще один словарь. Во вложенном словаре ключами будут слова, которые могут идти в тексте после текущего звена корпуса thinks и more могут идти в тексте после the, а значениями число появлений этих слов в тексте после нашего звена слово thinks появляется в тексте после слова the 1 раз, слово more после слова the 4 раза Перечитайте абзац выше несколько раз, чтобы точно разобраться. Обратите внимание, что вложенный словарь в данном случае это та же гистограмма, он помогает нам отслеживать звенья и частоту их появления в тексте относительно других слов. Надо заметить, что даже такая словарная база очень мала для надлежащей генерации текстов на естественном языке она должна содержать более 2. А еще лучше более 5. Но давайте рассмотрим ту словарную базу, которая получилась у нас. Цепь Маркова в данном случае строится аналогично первому примеру каждое следующее слово выбирается только на основании знаний о текущем слове, все остальные слова не учитываются.

Создаем генератор текста на основе цепей Маркова теория и практика. Проще всего это объясняется с точки зрения программы. Если говорить простыми словами, то Цепь Маркова это. Реализация программы, которая делает обход цепи Маркова из примера. Программа SCIgen, генерирующая псевдонаучные тексты, была. Применение цепей Маркова в фармакоэкономике html. Heart Association Failure Model NYHA model и программа предотвращения диабета 2го типа. Разработайте программу экспериментальных исследований дискретной цепи Маркова с матрицей переходных вероятностей Рис 1. Осуществите. Цепи Маркова. Маркова цепь Markov Chain марковский процесс с дискретным временем, заданный в измеримом пространстве. Цепь Маркова дискретный случайный процесс марковского типа это последовательность случайных событий с конечным числом вероятных исходов. C543&ssl=1' alt='Цепь Маркова Программу' title='Цепь Маркова Программу' />Поднявшийся в западных интернетах шум вынудил организаторов конференции отозвать приглашение и прикинуться дятлами, но им тогда вс равно хорошо досталось от спонсоров. Через некоторое время на статью обратили внимание в одном из российских универов. После некоторых правок литературного характера журнал опубликовал статью несуществующего ученого Михаила Жукова под названием Корчеватель алгоритм типичной унификации точек доступа и избыточности. Мини Игру Симулятор на этой странице. Главный редактор издаваемого в Курске Журнала научных публикаций аспирантов и докторантов Владимир Иванов в интервью РИА Новости подтвердил факт публикации статьи о Корчевателе. По его словам, материал был принят к публикации из за ошибочных действий рецензента. В сокращенном варианте, но зато с картинками, статью можно найти тут. Программа SCIgen, генерирующая псевдонаучные тексты, была написана за несколько лет до этого группой студентов Массачусетского технологического института с целью проверки качества рецензирования на псевдонаучных конференциях. Цепью Маркова называют такую последовательность случайных. При моделировании программы состояния цепи отождествляются с. Но это предположение неверно на сайте SCIgen легко убедиться, что в программе используется вручную составленная контекстно свободная грамматика. Статья, подписанная именем В. Родос, некоторое время считалась сгенерированной при помощи некоей отечественной программы РОДОС. Содержание креатива являет собой образец креационистско гуманитарного в худшем смысле этого слова бреда. И статья как статья, и журнал не ваковский, и раздел журнала специально предназначен для полемики читателей, то есть там публикуются материалы без рецензии. Вдобавок, оказалось, что Валерий Борисович Родос вполне уважаемый ученый и публицизд. Автор книг Теория и практика полемики, Правила дискуссии и уловки спора, и ряда художественных книг Байки и мозгоделки, мо, и СССю. Р, названия которых говорят сами за себя. В каких либо пристрастиях к дарвинизму или антидарвинизму не замечен умело маскировался диссидент же. А вот в умении красиво поиграться словами и юморнуть это да. Петросян такой Петросян. Создаем генератор текста на основе цепей Маркова теория и практика. Рассказывает Александр Деджу, студент Make Schools Product College. Эта статья дает общее представление о том, как генерировать тексты при помощи моделирования марковских процессов. В частности, мы познакомимся с цепями Маркова, а в качестве практики реализуем небольшой генератор текста на Python. Для начала выпишем нужные, но пока не очень понятные нам определения со страницы в Википедии, чтобы хотя бы примерно представлять, с чем мы имеем дело Марковский процесс случайный процесс, эволюция которого после любого заданного значения временного параметра t не зависит от эволюции, предшествовавшей t, при условии, что значение процесса в этот момент фиксировано. Марковская цепь частный случай марковского процесса, когда пространство его состояний дискретно т. Давайте разбираться. Основы. Первый пример предельно прост. Используя предложение из детской книжки, мы освоим базовую концепцию цепи Маркова, а также определим, что такое в нашем контексте корпус, звенья, распределение вероятностей и гистограммы. Несмотря на то, что предложение приведено на английском языке, суть теории будет легко уловить. Это предложение и есть корпус, то есть база, на основе которой в дальнейшем будет генерироваться текст. Оно состоит из восьми слов, но при этом уникальных слов только пять это звенья мы ведь говорим о марковской цепи. Для наглядности окрасим каждое звено в свой цвет И выпишем количество появлений каждого из звеньев в тексте На картинке выше видно, что слово fish появляется в тексте в 4 раза чаще, чем каждое из других слов One, two, red, blue. То есть вероятность встретить в нашем корпусе слово fish в 4 раза выше, чем вероятность встретить каждое другое слово из приведенных на рисунке. Говоря на языке математики, мы можем определить закон распределения случайной величины и вычислить, с какой вероятностью одно из слов появится в тексте после текущего. Вероятность считается так нужно разделить число появлений нужного нам слова в корпусе на общее число всех слов в нем. Для слова fish эта вероятность 5. Для каждого из остальных звеньев эта вероятность равна 1. Графически представить распределение случайных величин можно с помощью гистограммы. В данном случае, наглядно видна частота появления каждого из звеньев в предложении Итак, наш текст состоит из слов и уникальных звеньев, а распределение вероятностей появления каждого из звеньев в предложении мы отобразили на гистограмме. Если вам кажется, что возиться со статистикой не стоит, прочитайте наш перевод, который вас переубедит. И, возможно, сохранит вам жизнь. Суть определения. Теперь добавим к нашему тексту элементы, которые всегда подразумеваются, но не озвучиваются в повседневной речи начало и конец предложения Любое предложение содержит эти невидимые начало и конец, добавим их в качестве звеньев к нашему распределению Вернемся к определению, данному в начале статьи Марковский процесс случайный процесс, эволюция которого после любого заданного значения временного параметра t не зависит от эволюции, предшествовавшей t, при условии, что значение процесса в этот момент фиксировано. Марковская цепь частный случай марковского процесса, когда пространство его состояний дискретно т. Грубо говоря, мы моделируем процесс, в котором состояние системы в следующий момент времени зависит только от е состояния в текущий момент, и никак не зависит от всех предыдущих состояний. Представьте, что перед вами окно, которое отображает только текущее состояние системы в нашем случае, это одно слово, и вам нужно определить, каким будет следующее слово, основываясь только на данных, представленных в этом окне. В нашем корпусе слова следуют одно за другим по такой схеме Таким образом, формируются пары слов даже у конца предложения есть своя пара пустое значение Сгруппируем эти пары по первому слову. Мы увидим, что у каждого слова есть свой набор звеньев, которые в контексте нашего предложения могут за ним следовать Представим эту информацию другим способом каждому звену поставим в соответствие массив из всех слов, которые могут появиться в тексте после этого звена Разберем подробнее. Мы видим, что у каждого звена есть слова, которые могут стоять после него в предложении. Если бы мы показали схему выше кому то еще, этот человек с некоторой вероятностью мог бы реконструировать наше начальное предложение, то есть корпус. Пример. Начнем со слова Start. Далее выбираем слово One, так как по нашей схеме это единственное слово, которое может следовать за началом предложения. За словом One тоже может следовать только одно слово fish. Теперь новое предложение в промежуточном варианте выглядит как One fish. Дальше ситуация усложняется за fish могут с равной вероятностью в 2. End. Если мы предположим, что следующее слово two, реконструкция продолжится. Но мы можем выбрать и звено End. В таком случае на основе нашей схемы будет случайно сгенерировано предложение, сильно отличающееся от корпуса One fish. Мы только что смоделировали марковский процесс определили каждое следующее слово только на основании знаний о текущем. Давайте для полного усвоения материала построим диаграммы, отображающие зависимости между элементами внутри нашего корпуса. Овалы представляют собой звенья. Стрелки ведут к потенциальным звеньям, которые могут идти за словом в овале. Около каждой стрелки вероятность, с которой следующее звено появится после текущего ОтличноМы усвоили необходимую информацию, чтобы двигаться дальше и разбирать более сложные модели. Расширяем словарную базу. В этой части статьи мы будем строить модель по тому же принципу, что и раньше, но при описании опустим некоторые шаги. Если возникнут затруднения, возвращайтесь к теории в первом блоке. Возьмем еще четыре цитаты того же автора также на английском, нам это не помешает Today you are you. Oh, the thinks you can think up if only you try. Сложность корпуса увеличилась, но в нашем случае это только плюс теперь генератор текста сможет выдавать более осмысленные предложения. Дело в том, что в любом языке есть слова, которые встречаются в речи чаще, чем другие например, предлог в мы используем гораздо чаще, чем слово криогенный. Чем больше слов в нашем корпусе а значит, и зависимостей между ними, тем больше у генератора информации о том, какое слово вероятнее всего должно появиться в тексте после текущего. Проще всего это объясняется с точки зрения программы. Мы знаем, что для каждого звена существует набор слов, которые могут за ним следовать. А также, каждое слово характеризуется числом его появлений в тексте. Нам нужно каким то образом зафиксировать всю эту информацию в одном месте для этой цели лучше всего подойдет словарь, хранящий пары ключ, значение. В ключе словаря будет записано текущее состояние системы, то есть одно из звеньев корпуса например, the на картинке ниже а в значении словаря будет храниться еще один словарь. Во вложенном словаре ключами будут слова, которые могут идти в тексте после текущего звена корпуса thinks и more могут идти в тексте после the, а значениями число появлений этих слов в тексте после нашего звена слово thinks появляется в тексте после слова the 1 раз, слово more после слова the 4 раза Перечитайте абзац выше несколько раз, чтобы точно разобраться. Обратите внимание, что вложенный словарь в данном случае это та же гистограмма, он помогает нам отслеживать звенья и частоту их появления в тексте относительно других слов. Надо заметить, что даже такая словарная база очень мала для надлежащей генерации текстов на естественном языке она должна содержать более 2. А еще лучше более 5. Но давайте рассмотрим ту словарную базу, которая получилась у нас. Цепь Маркова в данном случае строится аналогично первому примеру каждое следующее слово выбирается только на основании знаний о текущем слове, все остальные слова не учитываются.

Статьи

- Программа Производственного Контроля В Школе Образец

- Стихи Для Взрослой Дочери От Мамы

- Книги По Пчеловодству Буткевич

- Lg 21Fs6rg ??????????

- 5 Класс Русский Язык Ладыженская Фгос

- Вакфу 3 Сезон Торрент

- Сериал Терранова 2 Сезон Торрент

- Лянча Призма Дизель Руководство Ремонта Експлуатации

- Программа Телеканала Ирбис Павлодар

- Титульный Лист Для Портфолио Учителя Шаблоны

- Панова И Амелькин Краеведенье